随机事件

- 随机事件A是指可能发生也可能不发生的事件

- 随机事件A发生的反面称为A的对立,记为\bar{A}

样本空间

一个事件中随机试验所有可能结果的集合

概率P(A)

- 对随机事件发生可能性大小的一个数值度量

- 概率取值的范围是0 到1

- 必然事件,P(A)=1

- 不可能事件,P(A)=0

概率的计算

- 古典概率法。P(A)=\frac{试验中包含事件A的所有结果个数}{实验中所有结果个数}

- 经验法。P(A)=\frac{历史数据中事件A发生的频率个数试验结果个数}{历史数据试验结果个数}。

- 经验主观概率法。由预测者根据其对事件的了解和专业知识对事件发生的概率做出主观估计。

概率的加法

P(A\cup B)=P(A)+P(B)-P(A\bigcap B),P(A\cup B)表示A或B其中一个发生的概率,P(A\bigcap B)表示A和B两个事情同时发生的概率

概率的乘法

P(AB)=P(B)P(A|B),P(AB)表示A和B两个事情同时发生的概率,P(A|B)表示在已知事件B发生的条件下事件A发生的概率

P(AB)=P(A)P(B|A),P(AB)表示A和B两个事情同时发生的概率,P(A|B)表示在已知事件B发生的条件下事件A发生的概率

事件独立

P(A|B)=P(A)

P(A\bigcap B)=P(A)*P(B)

条件概率

- 在已知事件B发生的条件下事件A发生的概率 P(A|B)。

- P(A|B)=\frac{P(A\bigcap B)}{P(B)}, 其中P(B)>0,P(A\bigcap B)表示A和B两个事情同时发生的概率

先验概率

先验概率P(A),指根据以往经验和分析得到的概率

后验概率

指通过调查或其它方式获取新的附加信息,对先验概率进行修正得到的概率。

P(A|B) =\frac{P(A)P(B|A)}{P(B)}

全概率公式

P(B)=\Sigma P(A_i)P(B|A_i)

贝叶斯公式

P(B_k|A)=\frac{P(B_kA)}{P(A)}=\frac{P(B_k)(A|B_k)}{P(A)}=\frac{P(B_k)(A|B_k)}{\sum P(B_i)P(A|B_i)}

概率的应用

- 支持度。关联产品A与B在所有交易中同时出现的概率

- 置信度。购买产品A的前提下,购买产品B的概率

- 提升度。购买产品A前提下购买产品B的概率与购买产品B随机发生概率之比。P(B|A)/P(B) (一般认为大于3是有价值的)

密度函数

Probability Density Function密度函数是概率论和统计学中的一个基本概念,它描述了随机变量取值的概率分布。

- 概率密度函数描述了连续型随机变量在给定区间内取值的相对可能性。它是一个非负函数,曲线下总面积等于1

- 随机变量 XX 落在区间 [a,b][a,b] 内的概率为:p(a\leqslant x\leqslant b)=\int_{a}^{b}f(x)dx

- 常见的密度函数有:正态分布(高斯分布)函数、均匀分布函数、指数分布分布函数

质量函数

概率质量函数描述了离散型随机变量取特定值的概率。

- 随机变量 XX 取特定值 xx 的概率为:P(X=x)=p(x)

- 对于任意x,p(x) > 0

- 常见质量函数有:二项分布函数、泊松分布函数、几何分布函数

分布函数

Cumulative Distribution Function, CDF用来描述随机变量取值分布特性的函数,概率的累积,可以用于连续型和离散型随机变量

- 对于连续型随机变量,它通过概率密度函数积分得到

- 对于离散型随机变量,它通过概率质量函数求和得到

似然函数

- 对于独立同分布的数据点,似然函数是所有数据点概率密度或概率质量函数的乘积

- 如果数据点不是独立的,那么需要考虑它们之间的联合概率分布。

伯努利试验

一种简单的随机试验,其结果只有两种可能:成功或失败。

二项分布

描述在固定次数的独立伯努利试验中成功的次数

- X\sim B(n, p),p是出现为真的概率,n是次数

泊松分布

指定时间范围内某事件出现次数的分布。

- P(x)=\frac{\lambda ^xe^{-\lambda }}{x!},x是可能观察到的事件数x=0,1,2…N,\lambda是单位时间(或单位空间)内事件平均发生的次数

- X\sim Poisson(\lambda), 期望和方差都等于 \lambda

正态分布(D分布)

- 密度函数:P(x)=\frac{1}{\sigma \sqrt{2\pi }}e^{-\frac{1}{2\sigma ^2}(x-\mu )^2},

- X\sim N(\mu , \sigma ^2),期望值是x=\mu,方差是\sigma^2

- 正态曲线的图形是关于x=\mu的对称钟形曲线,且峰值在x=\mu处

- \sigma越大,正态曲线越扁平;\sigma越小,正态曲线越陡峭

标准正态分布(Z分布)

- 密度函数:P(x)=\frac{1}{\sqrt{2\pi }}e^{-\frac{x^2}{2}}

- X\sim Z(0 , 1),期望值是0,方差是1

3\sigma经验法则

- 约68%的数据在 [\mu - \sigma, \mu + \sigma]

- 约95%的数据在 [\mu - 2\sigma, \mu + 2\sigma]

- 约99.7%的数据在 [\mu - 3\sigma, \mu + 3\sigma]

大数定律

随着试验次数的增加,样本均值趋近于总体均值的性质。大数定律是统计推断、保险、赌博和各种概率模型中非常重要的理论基础。

小概率原理

在大量重复试验中,发生概率极低的事件在一次试验中发生的可能性非常小,几乎可以忽略不计

中心极限定理和z值

- 中心极限定理。随着样本容量n的增大(n>=30),不论原来的总体是否服从正态分布,样本值的抽样分布都趋于正态分布,其分布的数学期望为总体均值\mu,方差为总体方差的1/n:X\sim N(\mu , \sigma ^2/n)

- z值,用于衡量一个观测值与总体均值之间的差异,以标准差为单位。z=\frac{X-\mu}{\sigma \sqrt{n}},X为样本均值,\mu为总体期望值,\sigma为总体标准差,n为样本数量

t分布和t值

- t分布。在总体标准差未知且样本量较小(通常n<30)时,用于估计总体均值的分布时的一种分布。t分布是对称的,均值为0,t分布的形状由自由度(degrees of freedom, df)参数决定,通常表示为 t(df)。自由度可以是任何正整数,且随着自由度的增加,t分布的形状越来越接近标准正态分布。

- t值。衡量了样本统计量(如样本均值)与假设值(如总体均值)之间的差异。t=\frac{\bar{x}-\mu}{s \sqrt{n}},\bar{x}为样本均值,\mu为总体均值,s为样本标准差,n为样本数量

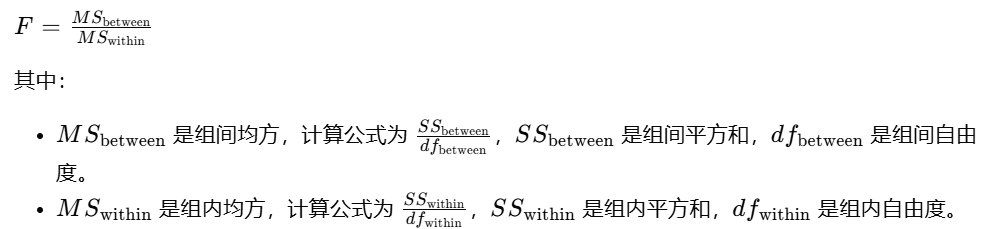

F分布和f值

F分布,也称为费舍尔-斯奈德分布(Fisher-Snedecor distribution),是一种连续概率分布,由两个独立的卡方分布随机变量的比值除以它们各自的自由度得到的。F值用于检验不同组的均值是否存在显著差异。

点估计

从样本数据中计算一个单一的数值,用来估计总体参数。点估计的组成有:样本均值、样本方差、样本中位数

区间估计

提供了一个数值范围(区间),用来估计总体参数。区间估计组成有:

- 置信区间:表示参数估计的区间

- 置信水平:通常用百分比表示,如95%,表示置信区间有95%的概率包含总体参数

- 误差范围(Margin of Error):区间估计中,样本统计量与总体参数之间可能的最大差异

假设检验

根据样本数据对总体参数进行推断,通常是采用逻辑上的反证法,如果结论是小概率,则接受假设。

P值

P 值是,根据样本数据计算出一个检验统计量(如 t 值、z 值或卡方值等)和检验统计量的分布。根据检验统计量的值和其分布,计算在零假设为真的情况下,得到该统计量值或更极端值的概率。

显著性水平\alpha

显著性水平是当原假设正确时却被拒绝的概率或风险。

统计显著

样本统计量的值落在了拒绝域内,研究者作出了拒绝原假设的决定。

假设检验的决策

- 如果统计检验的 P 值小于显著性水平\alpha,则拒绝零假设,支持备择假设。

- 如果 P 值大于或等于显著性水平\alpha,则不拒绝零假设,不支持备择假设。

零假设H_0

也叫原假设,问题的一个默认立场,通常是研究者试图推翻的假设。

- 提出者直接关心的指标。如工厂关心产品“合格率”,工商局关心产品“不合格率”

- =等号一般放在零假设。

备择假设H_1

零假设相对的假设,代表了研究者试图证明的效应或差异

备择假设的常见形式

- 单尾检验。右侧检验,H_1: \mu > \mu_0(例如,新药物的效果比旧药物好);左侧检验,H_1: \mu < \mu_0(例如,新工艺减少了生产成本)

- 双尾检验。H_1: \mu \neq \mu_0(例如,新方法与旧方法的效果不同)

第I类错误

原假设为真却别拒绝了,犯这类错误的概率用\alpha表示

第II类错误

原假设为假却没有拒绝,犯这类错误的概率用\beta表示。

- 当\alpha增加时\beta减少,要使\alpha和\beta同时减小的唯一办法是增加样本容量

P值决策

- 若p-值 >\alpha, 不拒绝 H0

- 若p-值 < \alpha, 拒绝 H0